文 徐令予

YouTube 上近日出现了一条题为《为什么量子计算机可能永远无法成功》的科普视频,引发了广泛关注。截至目前,该视频的观看量已超过 19 万,点赞数约 1 万,评论逾 1400 条。对于一条以基础物理与前沿科技为主题的科普视频,这样的传播效果实属罕见。

这条视频发布于 2025 年的最后一天,意味深长。在主流舆论仍在炒作量子计算议题的背景下,这样一则带有强烈质疑意味的作品,显得格外醒目,也为新一年中量子计算的发展前景投下了一层不确定的阴影。

视频播主是 Sabine Hossenfelder。她是一位受过严格学术训练的理论物理学家,曾长期从事量子引力及相关基础物理研究,目前任职于德国的科研机构。近年来,她以科普作者和视频创作者的身份受到广泛关注,其作品风格以质疑科技神话、反对科研叙事中的浮夸与炒作而著称。与常见的“科技过度乐观主义”不同,Hossenfelder 更强调物理定律、工程可行性以及社会与人文环境对技术发展的制约。她的立场并非否定新理论或新技术本身,而是主张在理论不确定性尚未澄清之前,对宏大技术承诺必须保持足够的理性审慎。

作为科学传播者,Hossenfelder 也具备相当可观的影响力。她运营的 YouTube 频道目前拥有约 170 万订阅者,累计观看量接近 3 亿次,在基础物理与科学文化领域中堪称明星级别。此外,她还长期作为博客作者与专栏撰稿人,在 Nature、New Scientist、Quanta Magazine 等国际媒体发表文章,并出版了多本科普著作。这些经历,使她在科学传播领域同时具备专业背景与公共影响力。

在本文后面的注释 中附有该视频核心内容的中文文字记录。为保持中立及客观性,文字纪录全部由机译生成,并附上英文原稿供读者对照参考。以下内容,则是我基于该视频所作的一些初步分析与评论。

量子计算面临的重大挑战可分为以下三个层面。

第一层:量子计算的物理基础仍处在未经验证的边界区间

任何具有实用意义的大规模量子计算机,都必须建立并操控一个超大规模、深度纠缠的量子系统,而这正是量子力学尚未被验证过的边界区间。然而,量子力学在这一极端区间——多体、宏观、长期维持并可反复操控的高阶纠缠态——从未被直接观测或系统检验过。量子计算的物理基础并非建立在已被充分验证的量子力学适用范围之内,而是建立在将其向大规模、多体、高度纠缠状态进行外推的前提之上。众所周知的事实是,物理系统尺寸增大时,量子效应为何会退化、在何种条件下退化,至今仍是一个悬而未决的物理基础问题。

在这一视角下,“噪声”也就不再只是工程层面的不完美,而可能来自原则上不可消除的物理背景,例如中微子或引力波等极其微弱却普遍存在的扰动。因此问题并非只是“现有技术还不够成熟”,而是量子计算所设想的那种可持续、可操控的超大规模纠缠态,是否能够在自然界真实存在?

第二层:量子计算并未构成通用意义上的算力跃迁

即便假定量子计算工作条件在上述物理的边界区间依旧成立,量子计算本身仍未必能够实现通用意义上的算力跃迁。

量子计算之所以被寄予“指数级加速”的期待,并不仅仅因为它使用了量子态,而是基于一种隐含的前提:自然界允许将量子叠加与干涉,当作一种可扩展、可累积、可反复调用的计算资源。在这一设想中,量子系统被理解为能够在指数增长的状态空间中并行演化,并通过干涉机制提取计算结果,从而在问题规模持续扩大时,与经典算法拉开数量级上的差距。

然而,视频中所呈现的一系列观点,正是对这一前提本身提出了质疑。如果自然界在更底层的计算意义上并不支持无限精度、无限可区分状态,或可被稳定提取的并行性——例如其演化在本体上更接近离散、逐步的更新过程——那么量子算法的“指数优势”就可能主要停留在形式层面,而难以转化为可随规模放大的实际加速度。

在这种图景下,量子计算或许能够在小规模、特定结构的问题上表现出优势,但这一优势并不会随着系统规模的提升而无限延伸。有理论估算认为,量子计算在规模上可能无法超过约 500 至 1000 个逻辑量子比特;而现有较为乐观的判断,则普遍将具有商业意义的应用门槛放在约 100 至 150 个逻辑量子比特左右。若这些估算接近真实,那么量子计算即便可行,其有效应用区间也将相当狭窄。

第二层质疑的并不是量子计算“能否运行”,而是进一步追问:即便它能够运行,其所带来的算法加速是否足以构成一种长期、通用的计算能力跃迁。在这一意义上,量子计算面临的挑战,并不只在于实现本身,还在于其加速潜力是否能够支撑人们对它所寄予的高度期待。

第三层:量子计算所依赖的理论本身可能仍需要修正

在这个层面上,讨论不再局限于量子计算的物理实现或算法效果,而是触及其更深层的理论前提:量子力学在极端复杂系统中是否仍然保持其标准形式。这一问题并非针对量子计算的,对量子力学可能需要修正的理论探索一直存在。

在若干修正模型中,波函数坍缩不再被视为一种仅与观测相关的抽象规则,而被引入为一种真实的、客观的物理过程。自发局域化模型正是其中具有代表性的一类。在这一类模型中,量子叠加并非原则上可以无限期维持,而是会随着系统规模与复杂度的增长,以一定概率自发坍缩。

在与量子计算相关的估算中,有研究指出:如果采用自发局域化模型,一个拥有约一百万个超导量子比特的量子计算机,其量子态的退相干时间可能仅为毫秒量级。相关作者据此指出,这样的时间尺度可能足以破坏在大型设备上运行具有实际意义的量子算法。需要强调的是,这种限制并非源于工程噪声、控制误差或环境耦合,而是来自理论层面对量子力学的根本性修正。

在这一图景下,量子计算面临的并不是“尚未解决的技术问题”,而是一种更为根本的可能性:即便工程与算法层面的困难被克服,支撑大规模量子叠加的理论前提本身,也未必在所有复杂度尺度上成立。如果此类修正模型在某种形式上接近真实,那么量子计算的可行性将不再仅由技术进步决定,而将直接受限于自然规律本身。

综上所述,量子计算面前存在三重根本性约束:其一,量子计算所依赖的物理边缘区间上,量子力学的适用性与正确性必须得到验证;其二,量子计算所带来的算法加速,是否具备随规模增长而完成算力跃迁的潜力;其三,支撑大规模量子叠加的理论前提,是否在高度复杂的物理系统中仍然成立。唯有这三项条件同时满足,量子计算所承载的宏大技术承诺才具备成立的基础。

注释

《为什么量子计算机可能永远无法成功》视频文字实录

视频时段:(1:11~5:23)

我并不认为在未来几十年内,量子计算机会有很好的应用场景,但那是另一回事。今天我想讨论的是那些认为量子计算机可能永远无法真正运作的人。

有些物理学家会讨厌我,因为我给怀疑者留出了空间。但我认为在这里必须保持谨慎。我们并没有任何证据表明,量子计算机会按照量子物理所预测的方式运作。这是一片尚未被检验的领域。我们从未能够测量过如此大规模的纠缠。相反,我们知道,当物体变得更大时,其量子效应会消失,而我们并不理解其中的原因。因此,我反而有些惊讶,为什么怀疑的声音没有更多。当然,有时我也会觉得,其实没有人真正知道任何东西是如何运作的,我们只是假装知道而已,所以或许我也不该感到惊讶。

话虽如此,确实有一些人认为量子计算机会败于噪声引发的错误。数学家兼计算机科学家 Gil Kalai 就曾提出,量子计算机必然存在不可避免的噪声,这将阻止它们获得相对于传统计算机的真正优势。物理学教授 Robert Alicki 也提出了类似的观点:如果对噪声进行现实建模,那么在量子计算机中纠错将变得不可能。

而同样是数学家和计算机科学家的 Leonid Levin 则认为,由于来自中微子或引力波的不可避免的微弱噪声,要在足够高的精度下维持量子相干性将是不可能的。

这三位都拥有该领域相关的学术背景,因此他们并非随意发表意见的人。不过,他们都没有给出定量预测,这也是我认为物理学界并未给予他们太多关注的原因。

此外,还有一些物理学家认为量子力学并非基础性的理论,而这就是为什么有人认为量子计算机行不通。比如 Stephen Wolfram 认为,世界在根本层面上是离散的,而量子物理也不例外。在他的模型中,他主张:“量子计算机最终不会占据优势。”

接下来是 Gerard ’t Hooft 的细胞自动机理论。这同样是一种离散的、逐步演化的理论,在他看来,这是量子物理的底层结构。他认为,“将一个拥有数百万位数字的整数分解为其素因子是不可能的。”

Tim Palmer 也认为量子物理在最终意义上必须是离散的。他计算得出,我们无法超过大约 500 到 1000 个逻辑量子比特。大多数估计认为,具有商业意义的应用大约会在 100 到 150 个量子比特左右变得可行。因此,如果 Palmer 是对的,那么我们能够使用量子计算机的区间将只有一个非常狭窄的窗口。

此外,还有一些对量子力学进行修正的普遍设想,例如自发局域性或 Penrose 的坍缩模型。在这两种模型中,波函数的坍缩被视为一种真实的物理过程,而不是某种我们不被允许讨论的“神秘现象”。

在前一种情况下,也就是自发局域化模型中,相关估算认为,一个拥有大约一百万个超导量子比特的量子计算机,其退相干时间约为一毫秒。作者们得出的结论是,这“可能会破坏在大型设备上运行具有实际意义的量子算法”。而在 Penrose 的模型中,我前几天自己做了一个估算,发现只有在拥有 10^18 个或更多超导量子比特的情况下,才可能观察到由引力诱导的坍缩效应。

我想再次强调,这种对量子计算的怀疑态度目前只来自少数人。大多数物理学家并不认为它是合理的。话虽如此,板块构造学说和细菌学说曾经也被视为边缘观点,但它们后来被证明是正确的。这也是我希望你了解这些观点的原因。就我个人而言,如果量子计算机成功了,我会庆祝;如果它们失败了……我同样会庆祝。

English Original 视频时段:(1:11~5:23)

I don’t see a good use case for quantum computers anywhere in the next decades, but that’s a different story. Today I want to look at those who think quantum computers will never properly work.

Some physicists will hate me because I give room to the sceptics. But I think one has to be careful here. We have no evidence that quantum computers will indeed work as quantum physics predicts. This is untested territory. We’ve never been able to measure such large amounts of entanglement before. Instead, we know that when objects become larger, their quantum effects go away. And we don’t understand why. So I am actually somewhat surprised that there isn’t more scepticism. Then again, sometimes I think that no one knows how anything works anyway, we’re all just pretending we do, so maybe I shouldn’t be surprised.

That said, there have been some who think that quantum computers will fall victim to errors induced by noise. The mathematician and computer scientist Gil Kalai, for example, has argued that quantum computers must have inevitable noise that will prevent them from ever reaching a true advantage against conventional computers. Then there is Robert Alicki, a physics professor, who has similarly argued that if one models noise realistically, then it becomes impossible to correct errors in quantum computers. And Leonid Levin, also a mathematician and computer scientist, has argued that it’ll be impossible to maintain coherence at sufficiently high precision due to inevitable tiny noise from neutrinos or gravitational waves.

These three all have relevant degrees in the field, so it’s not like they’re random guys with an opinion. However, neither of them has made quantitative predictions, which is why I think physicists don’t pay much attention to them.

There are also a few physicists who think that quantum mechanics isn’t fundamental and This is why quantum computers won’t work. Stephen Wolfram, for example, thinks that the world is fundamentally discrete, and that includes quantum physics. In his model, he has argued, “quantum computers aren’t going to come out ahead.”

Then there is Gerard ’t Hooft with his cellular automaton theory. This is also a discrete, step-by-step theory that, he believes, underlies quantum physics. He thinks that “factoring a number with millions of digits into its prime factors will not be possible.”

Tim Palmer, who also believes that quantum physics must ultimately be discrete, has calculated that we can’t go beyond 500 or 1000 logical qubits. Most estimates say that commercially interesting applications will become possible around 100 or 150 qubits. So, if Palmer is right, there’s only a small window in which we can use quantum computers.

Then there are the general expectations from modifications of quantum mechanics, such as spontaneous localization or Penrose’s collapse model. These are both models in which the collapse of the wavefunction is a real physical process and not some kind of magical thing that we’re not allowed to talk about.

In the former case, spontaneous localization, the estimate says that a quantum computer with about a million superconducting qubits will have a decoherence time of about a millisecond. The authors conclude that this “could spoil the quantum computation of practical algorithms on large devices.” In Penrose’s model, I did an estimate for this the other day and found one wouldn’t see evidence of gravitationally induced collapse until 10^18 superconducting qubits or more.

I want to stress again that this quantum computing scepticism comes from a small minority. Most physicists don’t believe it is justified. Then again, tectonic plate drift and germ theory were once considered fringe opinions, yet they turned out to be correct. This is why I want you to know about this. Personally, what I’ll do if quantum computers work, is that I’ll celebrate, and if they don’t work… I’ll also celebrate.

关于“离散”“算法加速”与量子计算优势的计算前提

为了说明第二层正文中所涉及的概念背景与理论语境,其目的并非为某一具体观点背书,而是澄清量子计算算法承诺背后所隐含的计算假设。

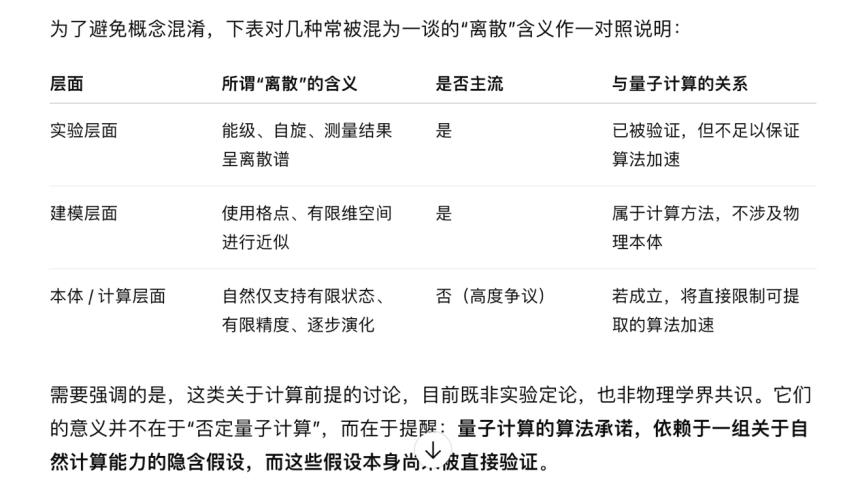

在关于量子计算的讨论中,“离散”一词常常被误解为量子力学中早已确立的事实,例如能级离散、粒子量子化或测量结果呈现离散谱。但这些意义上的“离散”,并非第二层讨论的核心。这里真正涉及的,是一种更强、更具争议性的主张:自然界在最根本的计算意义上,是否只允许有限精度、有限可区分状态,以及逐步、不可并行跳跃的演化结构。

在主流量子力学的标准表述中,量子系统的状态空间是连续的,其演化由连续的幺正变换描述,原则上允许任意精细的相位差异与指数增长的态空间结构。量子计算的算法承诺,正是建立在这一图景之上:量子叠加与干涉被视为一种可扩展、可累积、可反复调用的计算资源,从而有可能在问题规模扩大时,持续放大与经典算法之间的差距。

而第二层讨论中涉及的“本体论离散”观点,则对这一图景提出了根本性的限制设想。在这类设想中,自然界在底层更接近一种有限状态、逐步更新的计算结构;量子力学则被视为一种在中等尺度上有效的描述方式,而非自然界“计算能力”的直接接口。在这种情况下,即便量子系统在形式上呈现出指数增长的态空间,其可被物理区分、操控和稳定利用的自由度,仍可能存在严格上限。

一旦这一限制成立,其直接后果并不在于量子算法“是否存在”,而在于其可实现的实际加速度是否能够随规模持续放大。若可区分状态数、相位精度或并行性提取能力在物理上受到限制,那么量子算法的优势就可能只在小规模或特定结构的问题中显现,而难以构成一种通用、可扩展的计算范式跃迁。第二层正文中所提到的“窗口期”判断,正是这一逻辑在应用层面的自然推论。

为了避免概念混淆,下表对几种常被混为一谈的“离散”含义作一对照说明:

需要强调的是,这类关于计算前提的讨论,目前既非实验定论,也非物理学界共识。它们的意义并不在于“否定量子计算”,而在于提醒:量子计算的算法承诺,依赖于一组关于自然计算能力的隐含假设,而这些假设本身尚未被直接验证。

Gil Kalai

How Quantum Computers Fail: Noise and Quantum Error Correction

Gerard ’t Hooft

The Cellular Automaton Interpretation of Quantum Mechanics

Stephen Wolfram

A New Kind of Science(关于离散计算的相关章节)