IT之家 10 月 16 日消息,今年 9 月,华为盘古 718B 大模型凭借不堆数据、专注思考的训练哲学,在 SuperCLUE 榜单中一举冲至开源模型第三,成为业界焦点。

华为官方昨日宣布,

openPangu-Ultra-MoE-718B-V1.1 正式在 GitCode 平台开源,模型权重与技术细节全面公开。

华为官方介绍称,

openPangu-Ultra-MoE-718B-V1.1 是基于昇腾 NPU 训练的大规模混合专家(MoE)语言模型,总参数规模达 718B,激活参数量为 39B。该模型在同一架构下融合了“快思考”与“慢思考”两种能力,实现更高效、更智能的推理与决策。

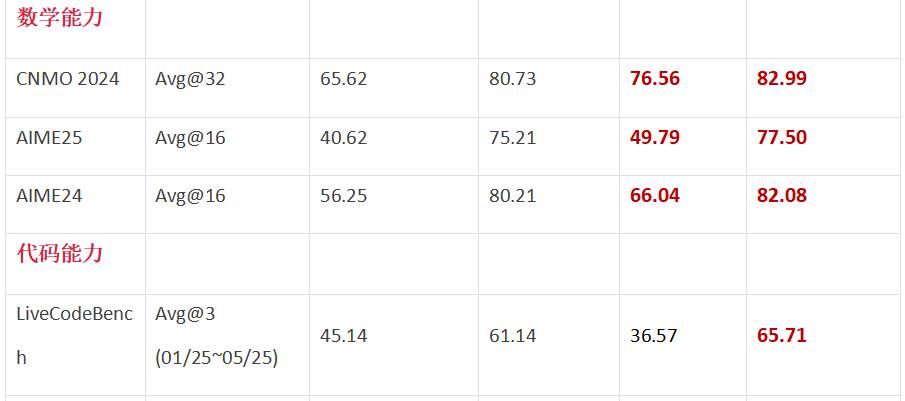

在 9 月最新 SuperCLUE榜单中,openPangu-718B 稳居开源模型总榜第三,在数学推理、科学推理、代码生成等六大核心维度均表现优异。尤其值得关注的是,其幻觉控制项得分高达 81.28,甚至超过部分闭源巨头,凸显出其在输出可靠性上的技术优势。

相比上一版本

openPangu-Ultra-MoE-718B-V1.0,V1.1 在 Agent 工具调用能力上显著增强,幻觉率进一步降低,模型的综合表现与稳定性也全面提升。

华为采用了业界先进的 Multi-head Latent Attention(MLA)、Multi-Token Prediction (MTP)以及高稀疏比混合专家架构,并在此基础上引入多项创新设计,以实现更优的性能与训练效率:

本次开源的 V1.1 版本在多个关键维度实现显著提升: